生成AIがローカル環境で出来るとのことで、試してみる。

修正がかかっていないモデルがあとのことで、それも試してみる。

https://gigazine.net/news/20230807-llama2-uncensored/

1.Ollamaをダウンロード

https://ollama.com/download

2.SetUpでインストール

Cドライブにインストールされる

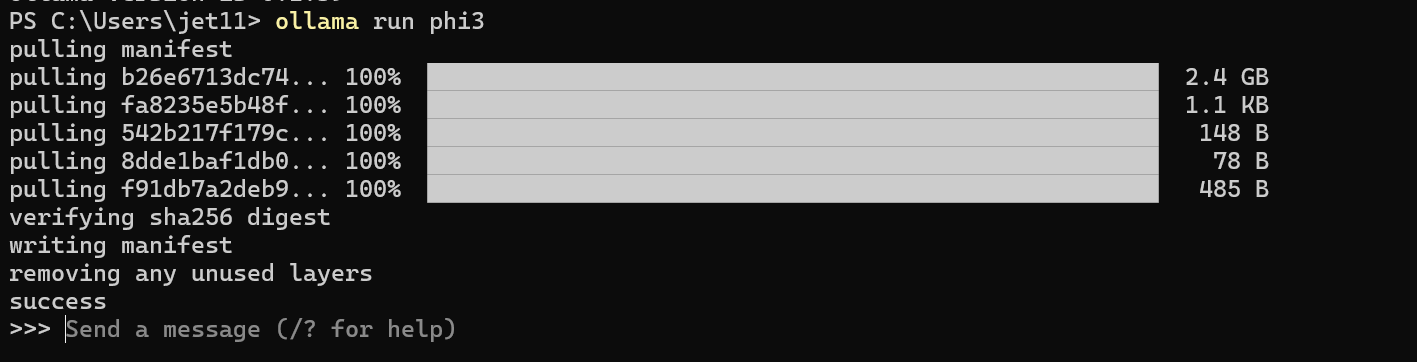

$ ollama run phi3

日本語も使える

$ ollama run llama3

複数の言語が扱えるとのこと6.プログラムもかけそうだ

Chromeのエクステンションが簡単とのこと

https://chromewebstore.google.com/detail/ollama-ui/cmgdpmlhgjhoadnonobjeekmfcehffco?pli=1

Chromeの拡張機能を開くと、すぐに使えた

Chromeの拡張機能を開くと、すぐに使えた

https://ollama.com/library/llama2-uncensored

$ ollama run llama2-uncensored

そして倫理に反する質問をしてみる